本文转自 半导体那些事儿

国产人工智能芯片的发展,一如早年间国产通用处理器和操作系统的发展,过份地追求完全独立、自主可控的怪圈,势必会如众多国产芯片一样逐渐退出历史舞台。

国外:技术寡头,优势明显

由于具有得天独厚的技术和应用优势,英伟达和谷歌几乎占据了人工智能处理领域80%的市场份额,而且在谷歌宣布其Cloud TPU开放服务和英伟达推出自动驾驶处理器Xavier之后,这一份额占比在2018年有望进一步扩大。其他厂商,如英特尔、特斯拉、ARM、IBM以及Cadence等,也在人工智能处理器领域占有一席之地。

当然,上述这些公司的专注领域却不尽相同。比如英伟达主要专注于GPU和无人驾驶领域,而谷歌则主要针对云端市场,英特尔则主要面向计算机视觉,Cadence则以提供加速神经网络计算相关IP为主。如果说前述这些公司还主要偏向处理器设计等硬件领域,那么ARM公司则主要偏向软件,致力于针对机器学习和人工智能提供高效算法库。

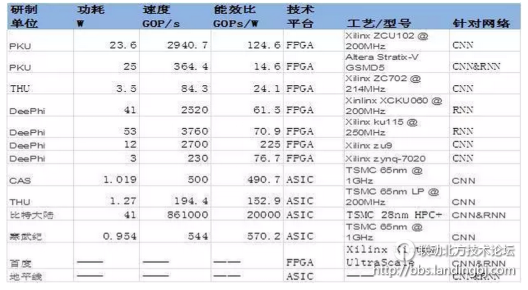

注:上述表格中所给为截止到2017年各研制单位公开可查的最新数据。

独占鳌头——英伟达

在人工智能领域,英伟达可以说是目前涉及面最广、市场份额最大的公司,旗下产品线遍布自动驾驶汽车、高性能计算、机器人、医疗保健、云计算、游戏视频等众多领域。其针对自动驾驶汽车领域的全新人工智能超级计算机Xavier,用NVIDIA首席执行官黄仁勋的话来说就是“这是我所知道的 SoC 领域非常了不起的尝试,我们长期以来一直致力于开发芯片。”

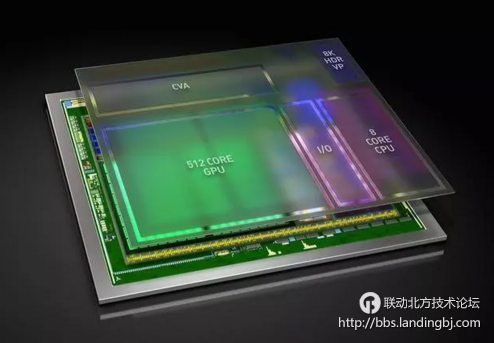

Xavier 是一款完整的片上系统 (SoC),集成了被称为 Volta 的全新 GPU 架构、定制 8 核 CPU 架构以及新的计算机视觉加速器。该处理器提供 20 TOPS(万亿次运算/秒)的高性能,而功耗仅为 20 瓦。单个 Xavier 人工智能处理器包含 70 亿个晶体管,采用最前沿的 16nm FinFET 加工技术进行制造,能够取代目前配置了两个移动 SoC 和两个独立 GPU 的 DRIVE PX 2,而功耗仅仅是它的一小部分。

而在2018年拉斯维加斯CES展会上,NVIDIA又推出了三款基于Xavier的人工智能处理器,包括一款专注于将增强现实(AR)技术应用于汽车的产品、一款进一步简化车内人工智能助手构建和部署的DRIVE IX和一款对其现有自主出租车大脑——Pegasus的修改,进一步扩大自己的优势。

产学研的集大成者——谷歌

如果你只是知道谷歌的AlphaGo、无人驾驶和TPU等这些人工智能相关的产品,那么你还应该知道这些产品背后的技术大牛们:谷歌传奇芯片工程师Jeff Dean、谷歌云计算团队首席科学家、斯坦福大学AI实验室主管李飞飞、Alphabet董事长John Hennessy和谷歌杰出工程师David Patterson。

时至今日,摩尔定律遇到了技术和经济上的双重瓶颈,处理器性能的增长速度越来越慢,然而社会对于计算能力的需求增速却并未减缓,甚至在移动应用、大数据、人工智能等新的应用兴起后,对于计算能力、计算功耗和计算成本等提出了新的要求。与完全依赖于通用CPU及其编程模型的传统软件编写模式不同,异构计算的整个系统包含了多种基于特定领域架构(Domain-Specific Architecture, DSA)设计的处理单元,每一个DSA处理单元都有负责的独特领域并针对该领域做优化,当计算机系统遇到相关计算时便由相应的DSA处理器去负责。而谷歌就是异构计算的践行者,TPU就是异构计算在人工智能应用的一个很好例子。

2017年发布的第二代TPU芯片,不仅加深了人工智能在学习和推理方面的能力,而且谷歌是认真地要将它推向市场。根据谷歌的内部测试,第二代芯片针对机器学习的训练速度能比现在市场上的图形芯片(GPU)节省一半时间;第二代TPU包括了四个芯片,每秒可处理180万亿次浮点运算;如果将64个TPU组合到一起,升级为所谓的TPU Pods,则可提供大约11500万亿次浮点运算能力。

计算机视觉领域的搅局者——英特尔

英特尔作为世界上最大的计算机芯片制造商,近年来一直在寻求计算机以外的市场,其中人工智能芯片争夺成为英特尔的核心战略之一。为了加强在人工智能芯片领域的实力,不仅以167亿美元收购FPGA生产商Altera公司,还以153亿美元收购自动驾驶技术公司Mobileye,以及机器视觉公司Movidius和为自动驾驶汽车芯片提供安全工具的公司Yogitech,背后凸显这家在PC时代处于核心位置的巨头面向未来的积极转型。

Myriad X就是英特尔子公司Movidius在2017年推出的视觉处理器(VPU,vision processing unit),这是一款低功耗的系统芯片(SoC),用于在基于视觉的设备上加速深度学习和人工智能——如无人机、智能相机和VR / AR头盔。Myriad X是全球第一个配备专用神经网络计算引擎的片上系统芯片(SoC),用于加速设备端的深度学习推理计算。该神经网络计算引擎是芯片上集成的硬件模块,专为高速、低功耗且不牺牲精确度地运行基于深度学习的神经网络而设计,让设备能够实时地看到、理解和响应周围环境。引入该神经计算引擎之后,Myriad X架构能够为基于深度学习的神经网络推理提供1TOPS的计算性能。

执“能效比”之牛耳——学术界

除了工业界和厂商在人工智能领域不断推出新产品之外,学术界也在持续推进人工智能芯片新技术的发展。

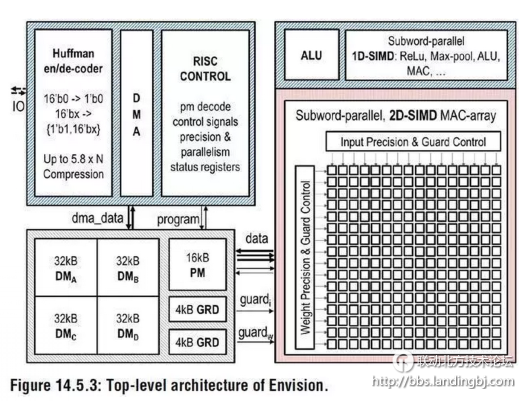

比利时鲁汶大学的Bert Moons等在2017年顶级会议IEEE ISSCC上面提出了能效比高达10.0TOPs/W的针对卷积神经网络加速的芯片ENVISION,该芯片采用28nm FD-SOI技术。该芯片包括一个16位的RISC处理器核,1D-SIMD处理单元进行ReLU和Pooling操作,2D-SIMD MAC阵列处理卷积层和全连接层的操作,还有128KB的片上存储器。

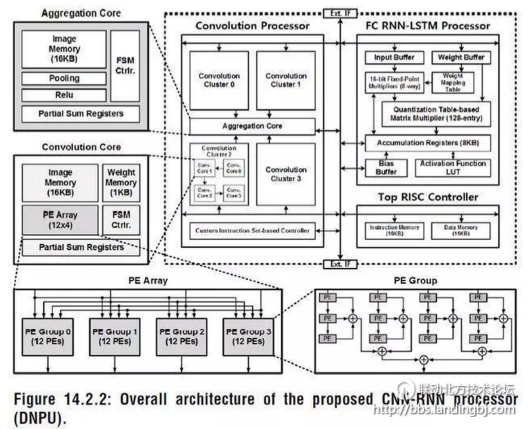

韩国科学技术院KAIST的Dongjoo Shin等人在ISSCC2017上提出了一个针对CNN和RNN结构可配置的加速器单元DNPU,除了包含一个RISC核之外,还包括了一个针对卷积层操作的计算阵列CP和一个针对全连接层RNN-LSTM操作的计算阵列FRP,相比于鲁汶大学的Envision,DNPU支持CNN和RNN结构,能效比高达8.1TOPS/W。该芯片采用了65nm CMOS工艺。

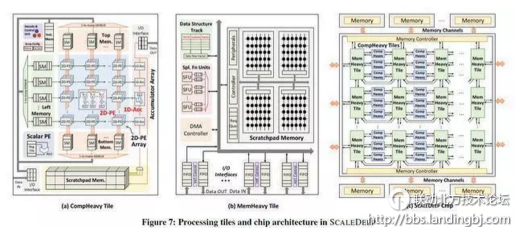

相比较于鲁汶大学和韩国科学技术院都针对神经网络推理部分的计算操作来说,普渡大学的Venkataramani S等人在计算机体系结构顶级会议ISCA2017上提出了针对大规模神经网络训练的人工智能处理器SCALLDEEP。该论文针对深度神经网络的训练部分进行针对性优化,提出了一个可扩展服务器架构,且深入分析了深度神经网络中卷积层,采样层,全连接层等在计算密集度和访存密集度方面的不同,设计了两种处理器core架构,计算密集型的任务放在了comHeavy核中,包含大量的2D乘法器和累加器部件,而对于访存密集型任务则放在了memHeavy核中,包含大量SPM存储器和tracker同步单元,既可以作为存储单元使用,又可以进行计算操作,包括ReLU,tanh等。

而一个SCALEDEEP Chip则可以有不同配置下的两类处理器核组成,然后再组成计算簇。论文中所用的处理平台包括7032个处理器tile。论文作者针对深度神经网络设计了编译器,完成网络映射和代码生成,同时设计了设计空间探索的模拟器平台,可以进行性能和功耗的评估,性能则得益于时钟精确级的模拟器,功耗评估则从DC中提取模块的网表级的参数模型。该芯片仅采用了Intel 14nm工艺进行了综合和性能评估,峰值能效比高达485.7GOPS/W。

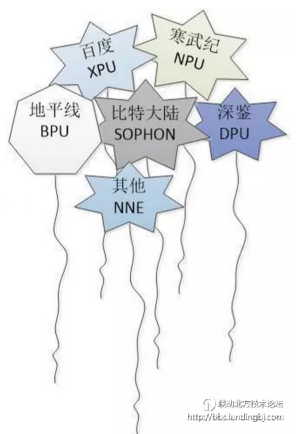

国内:百家争鸣,各自为政

可以说,国内各个单位在人工智能处理器领域的发展和应用与国外相比依然存在很大的差距。由于我国特殊的环境和市场,国内人工智能处理器的发展呈现出百花齐放、百家争鸣的态势,这些单位的应用领域遍布股票交易、金融、商品推荐、安防、早教机器人以及无人驾驶等众多领域,催生了大量的人工智能芯片创业公司,如地平线、深鉴科技、中科寒武纪等。尽管如此,国内起步较早的中科寒武纪却并未如国外大厂一样形成市场规模,与其他厂商一样,存在着各自为政的散裂发展现状。

除了新兴创业公司,国内研究机构如北京大学、清华大学、中国科学院等在人工智能处理器领域都有深入研究;而其他公司如百度和比特大陆等,2017年也有一些成果发布。

注:上述表格中所给为截止到2017年各研制单位公开可查的最新数据。

全球AI芯片界首个独角兽——寒武纪

2017年8月,国内AI芯片初创公司寒武纪宣布已经完成1亿美元A轮融资,战略投资方可谓阵容豪华,阿里巴巴、联想、科大讯飞等企业均参与投资。而其公司也成为全球AI芯片界首个独角兽,受到国内外市场广泛关注。

寒武纪科技主要负责研发生产AI芯片,公司最主要的产品为2016年发布的寒武纪1A处理器(Cambricon-1A),是一款可以深度学习的神经网络专用处理器,面向智能手机、无人机、安防监控、可穿戴设备以及智能驾驶等各类终端设备,在运行主流智能算法时性能功耗比全面超越传统处理器。目前已经研发出1A、1H等多种型号。与此同时,寒武纪也推出了面向开发者的寒武纪人工智能软件平台 Cambricon NeuWare,包含开发、调试和调优三大部分。

软硬件协同发展的典范——深鉴科技

深鉴科技的联合创始人韩松在不同场合曾多次提及软硬件协同设计对人工智能处理器的重要性,而其在FPGA领域顶级会议FPGA2017最佳论文ESE硬件架构就是最好的证明。该项工作聚焦于使用 LSTM 进行语音识别的场景,结合深度压缩(Deep Compression)、专用编译器以及 ESE 专用处理器架构,在中端的 FPGA 上即可取得比 Pascal Titan X GPU 高 3 倍的性能,并将功耗降低 3.5 倍。

在2017年10月的时候,深鉴科技推出了六款AI产品,分别是人脸检测识别模组、人脸分析解决方案、视频结构化解决方案、ARISTOTLE架构平台,深度学习SDK DNNDK、双目深度视觉套件。而在人工智能芯片方面,公布了最新的芯片计划,由深鉴科技自主研发的芯片“听涛”、“观海”将于2018年第三季度面市,该芯片采用台积电28nm工艺,亚里士多德架构,峰值性能 3.7 TOPS/W。

对标谷歌TPU——比特大陆算丰

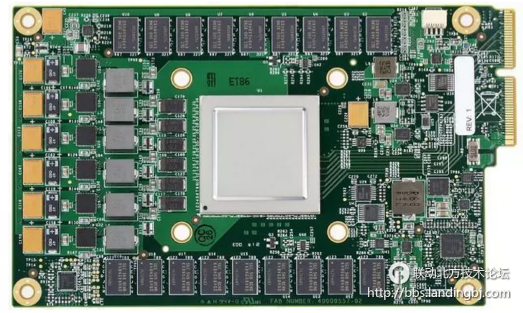

作为比特币独角兽的比特大陆,在2015年开始涉足人工智能领域,其在2017年发布的面向AI应用的张量处理器算丰Sophon BM1680,是继谷歌TPU之后,全球又一款专门用于张量计算加速的专用芯片(ASIC),适用于CNN / RNN / DNN的训练和推理。

BM1680单芯片能够提供2TFlops单精度加速计算能力,芯片由64 NPU构成,特殊设计的NPU调度引擎(Scheduling Engine)可以提供强大的数据吞吐能力,将数据输入到神经元核心(Neuron Processor Cores)。BM1680采用改进型脉动阵列结构。2018年比特大陆将发布第2代算丰AI芯片BM1682,计算力将有大幅提升。

百家争鸣——百度、地平线及其他

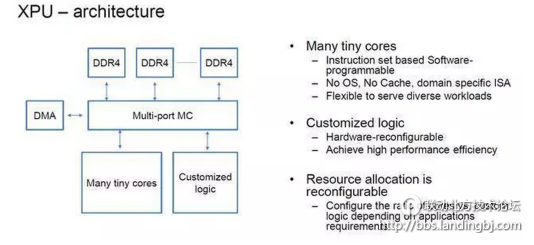

在2017年的HotChips大会上,百度发布了XPU,这是一款256核、基于FPGA的云计算加速芯片,用于百度的人工智能、数据分析、云计算以及无人驾驶业务。在会上,百度研究员欧阳剑表示,百度设计的芯片架构突出多样性,着重于计算密集型、基于规则的任务,同时确保效率、性能和灵活性的最大化。

欧阳剑表示:“FPGA是高效的,可以专注于特定计算任务,但缺乏可编程能力。传统CPU擅长通用计算任务,尤其是基于规则的计算任务,同时非常灵活。GPU瞄准了并行计算,因此有很强大的性能。XPU则关注计算密集型、基于规则的多样化计算任务,希望提高效率和性能,并带来类似CPU的灵活性。在2018年百度披露更多关于XPU的相关信息。

2017年12月底,人工智能初创企业地平线发布了中国首款全球领先的嵌入式人工智能芯片——面向智能驾驶的征程(Journey)1.0处理器和面向智能摄像头的旭日(Sunrise)1.0处理器,还有针对智能驾驶、智能城市和智能商业三大应用场景的人工智能解决方案。“旭日 1.0”和“征程 1.0”是完全由地平线自主研发的人工智能芯片,具有全球领先的性能。

为了解决应用场景中的问题,地平线将算法与芯片做了强耦合,用算法来定义芯片,提升芯片的效率,在高性能的情况下可以保证它的低功耗、低成本。具体芯片参数尚无公开数据。

除了百度和地平线,国内研究机构如中国科学院、北京大学和清华大学也有人工智能处理器相关的成果发布。

总结——对国产人工智能芯片的一点愚见

正如前文所述,在人工智能芯片领域,国外芯片巨头占据了绝大部分市场份额,不论是在人才聚集还是公司合并等方面,都具有绝对的领先优势。而国内人工智能初创公司则又呈现百家争鸣、各自为政的纷乱局面;特别是每个初创企业的人工智能芯片都具有自己独特的体系结构和软件开发套件,既无法融入英伟达和谷歌建立的生态圈,又不具备与之抗衡的实力。

国产人工智能芯片的发展,一如早年间国产通用处理器和操作系统的发展,过份地追求完全独立、自主可控的怪圈,势必会如众多国产芯片一样逐渐退出历史舞台。借助于X86的完整生态,短短一年之内,兆芯推出的国产自主可控x86处理器,以及联想基于兆芯CPU设计生产的国产计算机、服务器就获得全国各地党政办公人员的高度认可,并在党政军办公、信息化等国家重点系统和工程中已获批量应用。

当然,投身于X86的生态圈对于通用桌面处理器和高端服务器芯片来说无可厚非,毕竟创造一个如Wintel一样的生态链已绝非易事,我们也不可能遇见第二个乔布斯和苹果公司。而在全新的人工智能芯片领域,对众多国产芯片厂商来说,还有很大的发展空间,针对神经网络加速器最重要的就是找到一个具有广阔前景的应用领域,如华为海思麒麟处理器之于中科寒武纪的NPU;否则还是需要融入一个合适的生态圈。另外,目前大多数国产人工智能处理器都针对于神经网络计算进行加速,而能够提供单芯片解决方案的很少;微控制器领域的发展,ARM的Cortex-A系列和Cortex-M系列占据主角,但是新兴的开源指令集架构RISC-V也不容小觑,完全值得众多国产芯片厂商关注。

该贴被huang.wang编辑于2018-7-3 15:50:10

技术讨论

技术讨论