最近看了一系列新闻,对于人工智能未来对于人类的发展,威胁论有之,帮助论有之。

这里整理一下业内大佬的看法,分享给大家。

吴恩达:人工智能短期内不会超过人类

吴恩达对于人工智能的态度转变从2015年“无须担心人工智能毁灭人类”,到2016年“人工智能会统治世界?这种想法太不切实际了”,最近一次,2017年7月,Coursera联合创始人、百度前首席科学家吴恩达在哈佛商业评论举办的一个活动上进行了人工智能主题的报告,报告中吴恩达提到人们无需对于人工智能过于担心,在短期内人工智能依然无法超越人类的能力,但是技术的发展速度是人们无法预知的。

吴恩达说到:“作为一名人工智能从业人员,我开发和推出了多款人工智能产品,但没有发现人工智能在智力方面超过人的可能性。我认为,工作岗位流失是个大问题,希望我们能致力于解决这一问题,而非考虑那些科幻作品中才可能出现的场景。”

不过,吴恩达也没有明确表示未来人工智能不会超过人类。

除此之外,吴恩达还认为,虽然人工智能和其他科学技术可以帮助人类创造更多的财富,但是想要创建一个和谐公正的社会还是离不开人类的智慧。他还特地强调了受教育的重要性,并呼吁社会给那些工作岗位受到人工智能威胁的人群,提供更多的受教育机会。“给教育系统增加更多的元素,让那些工作岗位有可能被取代的人,能够有机会重新找到工作。”他说。

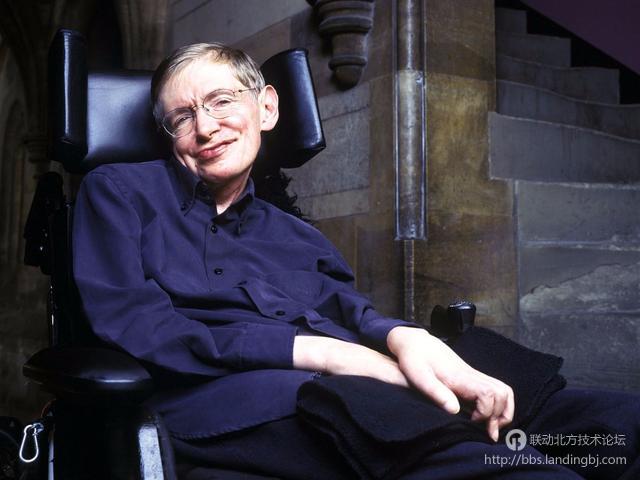

霍金:人工智能的崛起可能是人类文明的终结

霍金对于人工智能的看法一直处于一个比较消极的状态,也不止一次提出“人工智能威胁论”。早在2015年,霍金就提醒人类警惕人工智能。在2017年全球移动互联网大会(GMIC)上,霍金通过视频发表了题为《让人工智能造福人类及其赖以生存的家园》的主题演讲。演讲中他表示,人工智能的崛起可能是人类文明的终结。

下面分享截取部分霍金的演讲内容。

“文明所提产生的一切都是人类智能的产物,我相信生物大脑可以达到的和计算机可以达到的,没有本质区别。因此,它遵循了“计算机在理论上可以模仿人类智能,然后超越”这一原则。但我们并不确定,所以我们无法知道我们将无限地得到人工智能的帮助,还是被藐视并被边缘化,或者很可能被它毁灭。的确,我们担心聪明的机器将能够代替人类正在从事的工作,并迅速地消灭数以百万计的工作岗位。

在人工智能从原始形态不断发展,并被证明非常有用的同时,我也在担忧创造一个可以等同或超越人类的事物所导致的结果:人工智能一旦脱离束缚,以不断加速的状态重新设计自身。人类由于受到漫长的生物进化的限制,无法与之竞争,将被取代。这将给我们的经济带来极大的破坏。未来,人工智能可以发展出自我意志,一个与我们冲突的意志。尽管我对人类一贯持有乐观的态度,但其他人认为,人类可以在相当长的时间里控制技术的发展,这样我们就能看到人工智能可以解决世界上大部分问题的潜力。但我并不确定。

……

现在,关于人工智能的研究正在迅速发展。这一研究可以从短期和长期来讨论。一些短期的担忧在无人驾驶方面,从民用无人机到自主驾驶汽车。比如说,在紧急情况下,一辆无人驾驶汽车不得不在小风险的大事故和大概率的小事故之间进行选择。另一个担忧在致命性智能自主武器。他们是否该被禁止?如果是,那么“自主”该如何精确定义。如果不是,任何使用不当和故障的过失应该如何问责。还有另外一些担忧,由人工智能逐渐可以解读大量监控数据引起的隐私和担忧,以及如何管理因人工智能取代工作岗位带来的经济影响。

长期担忧主要是人工智能系统失控的潜在风险,随着不遵循人类意愿行事的超级智能的崛起,那个强大的系统威胁到人类。这样错位的结果是否有可能?如果是,这些情况是如何出现的?我们应该投入什么样的研究,以便更好的理解和解决危险的超级智能崛起的可能性,或智能爆发的出现?

当前控制人工智能技术的工具,例如强化学习,简单实用的功能,还不足以解决这个问题。因此,我们需要进一步研究来找到和确认一个可靠的解决办法来掌控这一问题。

近来的里程碑,比如说之前提到的自主驾驶汽车,以及人工智能赢得围棋比赛,都是未来趋势的迹象。巨大的投入倾注到这项科技。我们目前所取得的成就,和未来几十年后可能取得的成就相比,必然相形见绌。而且我们远不能预测我们能取得什么成就,当我们的头脑被人工智能放大以后。也许在这种新技术革命的辅助下,我们可以解决一些工业化对自然界造成的损害。关乎到我们生活的各个方面都即将被改变。简而言之,人工智能的成功有可能是人类文明史上最大的事件。

但是人工智能也有可能是人类文明史的终结,除非我们学会如何避免危险。我曾经说过,人工智能的全方位发展可能招致人类的灭亡,比如最大化使用智能性自主武器。今年早些时候,我和一些来自世界各国的科学家共同在联合国会议上支持其对于核武器的禁令。我们正在焦急的等待协商结果。目前,九个核大国可以控制大约一万四千个核武器,它们中的任何一个都可以将城市夷为平地,放射性废物会大面积污染农田,最可怕的危害是诱发核冬天,火和烟雾会导致全球的小冰河期。这一结果使全球粮食体系崩塌,末日般动荡,很可能导致大部分人死亡。我们作为科学家,对核武器承担着特殊的责任,因为正是科学家发明了它们,并发现它们的影响比最初预想的更加可怕。”

该贴被huang.wang编辑于2018-2-9 16:59:56

技术讨论

技术讨论