“黑夜给了我黑色的眼睛,我却用它来寻找光明”

--新一代人工智能的底线

在众多大众媒体眼中,2016年似乎是AI崛起的元年,Alpha GO(阿尔法狗)击败李世石一举成名,众多传统行业以及科技、互联网巨头纷纷布局人工智能。但其实人工智能并不是一个新鲜事物,而是一个相对比较“老”的领域,比很多计算机科学的分支都要古老,六十年来已经起起落落过了。那么在新一波热潮兴起之际,对于人工智能自然就有一个疑问,就是过去的那么多年为什么都来回折戟沉沙?现在仅仅因为硬件变快了、数据变大了,人工智能就可以崛起了?

的确,人工智能终将而且很快就会改变世界,但前提是,人工智能首先要改变自己,要从那些形而上学或者蛮力计算的套路解放出来。暂且不论类似《奇点来临》那些关于伦理、政治等的讨论,痛定思痛,纯粹从技术角度,新一代的人工智能应当具备如下要义,或者说,新一代人工智能的定义:

底线一:理论基础上自律(或者说,自完备)

任何一个获得快速发展的科技领域,一般都伴随着理论基础的夯实,比如二进制对于冯.诺依曼体系计算机发展的重要推动,就是一个例子。且不说数学中依靠自律性、奠基性很强的交换律、结合律、分配律等等来构建大厦,就是计算机科学中的信息熵(香农)、机器学习中的统计公式(象贝叶斯条件概率),还有数据结构及其算法复杂度等等,无一不透着其基石自完备的光芒。

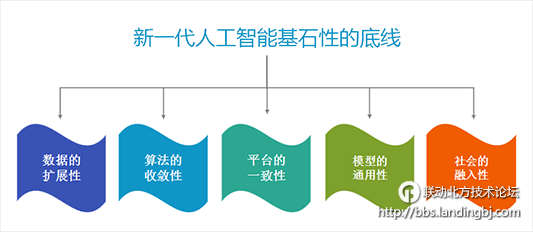

在新一代人工智能中,我们也需要有几个基石性的底线:

【数据的扩展性】

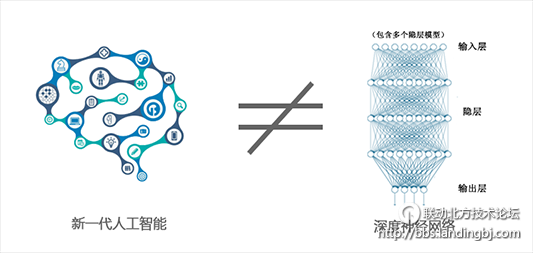

对人工智能有一定关注的人都知道,深度学习是近十年来人工智能领域取得的最重要突破之一,当前大热的阿尔法狗就是深度神经网络的典型。神经网络、深度学习,它们都是从无到有的,通过训练网络中的各连接参数(权重),在给定的输入与输出条件下,然后用其算出任意旧或新激励下的响应或执行。这类比较明显的缺点是,针对新的领域,或者哪怕是输入输出的扩维,都需要重新学习与计算,这可以看作是深度学习自身深入学习的能力问题。

现在所有的(深度)神经网络学习的方法,一旦网络结构变化,它的学习过程都是要从头开始学,要把数据重新进行一次训练。这跟人的大脑的学习能力相比,确实有很大的差距,大脑中的知识是具有累加性的,并且具有可扩展性和举一反三的能力。所以新一代人工智能在这方面的目标,要想能跟人的大脑一样,就必须具备可累积性和可扩展性。

当然,虽然(深度)神经网络的缺点比较明显,但不表示它没有用武之地。题外话,它的厉害之处,其实并不仅仅是模拟神经元的工作,而是象数字集成电路一样,它能实现与非门与异或运算,进而可以拓展组合出各种非线性可能。

【算法的收敛性】

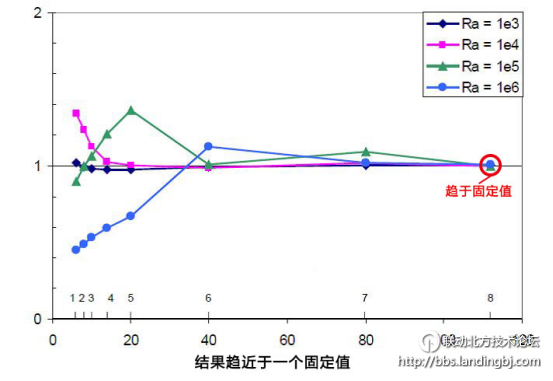

按照教科书上的讲法,算法的所谓收敛,是指随着迭代的进行,算法的结果与真实结果的误差越来越小,且趋近于一个固定的值。其实讲通俗点就是说已经得到了数值计算的解,再继续迭代,结果也不会有太大变化了。而发散则与收敛对应,发散是无论迭代次数多大,收敛曲线均一直跳动无法趋于定值。

考察一个算法这方面的性能,通常会用到局部收敛能力和全局收敛能力这两个指标。局部收敛能力是指在一定区域内能够无穷接近最优解的能力,而全局收敛能力是指找到全局最优解所在大致位置的能力。打个生活的比方,局部搜索能力对应着,人对于自己所遇到的事情刨根究底,从而精通的能力;举个例子,这种能力可以是与人交往的能力,学好功课的能力,创业的能力,做饭的能力,下围棋的能力,甚至蹭饭的能力。而全局收敛能力则对应着一个人的是否对全局信息有较好的把握,在不断失败的尝试中,然后找到了自己喜欢的一种生活状态和定位。

最优解的导向,对于任何智能算法的性能都是很重要的,对于新一代人工智能也是如此,它不仅需要有局部收敛能力,同样需要有全局收敛能力,那样才算得上是真正的智能,不然就丢失标靶、无法聚焦,无法确定性的分析理解和判断。

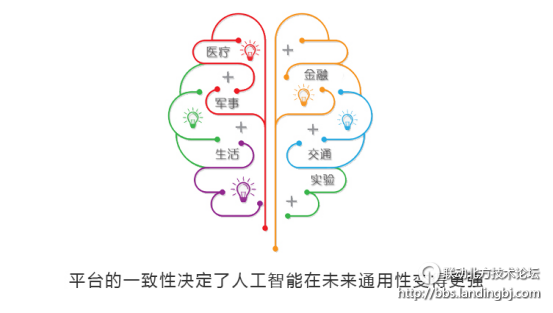

【平台的一致性】

目前,在人工智能领域流行的是比较狭隘的人工智能系统,它们只可以做特定的事情。比如自动驾驶开车、语音识别转换成文本、分析特定的基因数据、以及了解特定的治疗方案等等。由于其特定平台设计的限制,导致每一个人工智能的项目都是在特定的领域做特定的工作,各自为战、各有特色。但与人工智能相比,人类的大脑明显是有着更大的通用性,是一种一致化的平台。人类可以应对各种各样的环境,这种能力是与生俱来,无需学习。打个比方,人出生的时候根本没有互联网,在学校也根本没有学习如何利用互联网,但是人类有适应的能力,能够快速适应互联网的环境。通过这种天然的一致性平台,人类可以进入到一个新的领域,了解它的背景,并利用通用智能找到解决方案。

虽然目前人工智能已有的项目,其范围比较狭窄,但是依照发展趋势来看,人工智能将来会变的越来越通用,它们不仅会越来越智能,同时范围和目的也会更加通用,那么承载它的平台就必须是一致性的,对于各种范围和场景有同构的核与异构的表。

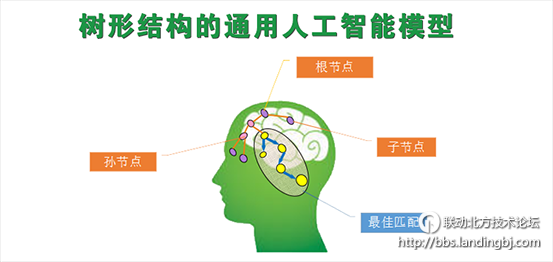

【模型的通用性】

承接上节,作为一致性平台所代表的通用智能的另一面,则自然而然是模型的通用性,即伴随的另一个轮子。照搬当前流行的分类法,强AI在学术界一般指通用人工智能,即借助通用的数学模型,能够最大限度概括智能的本质。

现在,很多人都在关注产业和人工智能经济带来的机会,但如果仔细来看,近来人工智能的一些显性突破,似乎并没有直接带来商业方面明显的价值。因为,现有人工智能大部分的方案比较笨重、单一、昂贵,并由此产生了一些不太乐观的后果。比如垂直行业,像网络安全、像金融医疗、像用户画像、像对天文学数据学的处理等,目前的状态都是处在一个比较薄弱的数据状态,数据量很大,但技术手段和分析手段没有达到科学家和用户所需要的功能。

通用型人工智能明显是复杂得多,因为我们面对的世界太庞大,上下五千年,东西两半球,小到柴米油盐,大到两次大战,啥事没发生过,还有人的各种感情问题,比如“你是风儿我是沙”这样卿卿我我的东西,让计算机能够理解,建立这样全方位的知识体系肯定难得多,也重要得多。

【社会的融入性】

(或者说,“AI即UI”的设定)

前述都是客观技术的范畴比较多,我们再来看看主观和体验的方面。其实近几年,各类智能产品早已在渐渐融入我们的生活,作为辅助性的工具改变了我们的某些生活习惯。那让我们畅想一下,如果未来的AI不仅仅是辅助性的工具,而是能准确揣测并自动执行用户的需求,即未来的AI不是仅仅会下象棋,围棋,而是会跟人做交互,它能根据具体的情况作出相应的动作,会是什么样的体验?

报告会上,我们不需要做任何记录。电脑能够将其“听”到的语音直接转化为文字,以文档形式保存起来;在展示会上,我们不需要任何形式的鼠标,只要轻轻挥一下手指,就能控制PPT的播放。在家里看电视,你只要说出想看的电视节目或电视剧名称,电视机就会自动检索数据库,找到并播放你想看的节目。

再打个比方,开门只需象阿里巴巴那样说声“芝麻开门”就可以了,或者感应式的自动识别身份并开锁;而手一招,具备自动驾驶能力的汽车直接开到面前停下来,上车后能将乘客的主动和被动关注点全方位展现......在AI即UI的时代里,人们的很多生活习惯和行为方式将被打破,代之以全新的人机互动体验。

底线二:全链路径上闭环(或者说,互耦合)

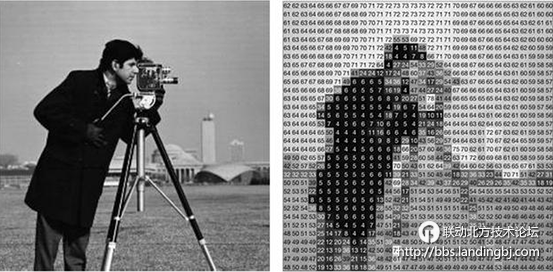

【有并行与分层能力的感知】

这个是对输入环节的要求。当前主流实现人工智能的手段,主要是通过从行为上模拟人类智能;但智能行为、特别是思维对应的信息处理机制上,目前人与机器存在着巨大差别。

一个是并行和分层计算的能力,比如早晨当人一睁开眼,面前所有的东西都一目了然,柜子、床、天花板、窗户、窗外的天空等等,以及它们的各种诸如纹理、颜色、位置等等各种细节;这种能力,哪怕是计算能力巨大的超级电脑,都难以望其项背;毕竟当前计算机本质上是串行计算的,并且以逻辑处理的方式去分析感知目标对象;并不是人的智能这种天然并行与分层的融和计算方式。

另一个是前馈的机制和能力,当前主流实现主要是面向应用收集一些相关的数据,通过统计学习或神经网络训练等方法,来提取一些显式或隐式的规则以解决问题。而人脑是一个不断学习、不断进化的信息处理系统;人从一出生开始,人脑就在通过视觉、听觉、触觉等多感知通道获取各种知识,而后在学习和感知过程中,这些通过各种场景、经历等长期积累的知识,都在感知过程中发挥着潜移默化的作用。就是说,没有核心大脑的前馈参与,只是单纯的去感知,并不是完全意义上的智能感知;

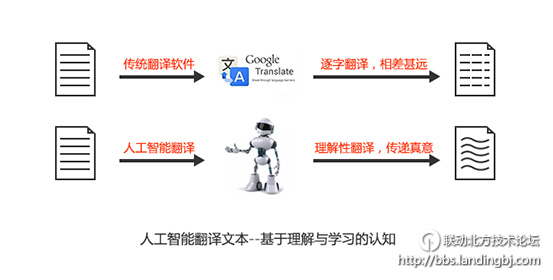

【基于理解和自学习的认知】

这个是对中枢环节的要求。打个比方,相信大家对主流的机器翻译都不陌生,其结果经手工改一改有时还可凑合用;造成这个差强人意效果的主要原因是,在他们的知识体系里关联度不够立体、不够多维、不够强,毕竟是以词汇翻译为基础,然后把他们拼接起来。由于他们并没有理解需要翻译句子的语义,所以有时候翻译的结果与真实的意思相差甚远;何况机器翻译早在很多年前就已经诞生,发展很多年了,并不是个全新的事物。

其实在当前人工智能领域里这是个普遍的现象,更多的是单纯的机械式的抽取和比对特征(词)。而真正的智能必须要能理解对象目标,象人类所做的那样,毕竟即使是人类的语言也是一直在进步和多样化。

与此对应,鉴于已知与未知的海量与浩瀚,毋庸置疑,这个过程显然需要有很好的相对精巧的自学习能力。如果只是人工梳理了再喂给电脑,一是知识相对有限,二是无法超越人类。

【决策变换下的合成与执行】

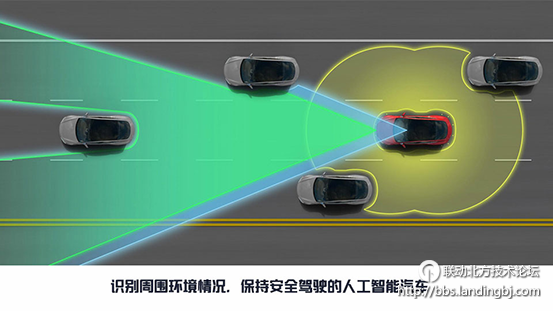

这个是对输出环节的要求。真正的智能,不仅能感知和理解目标对象,还应该能灵活的应对各种场合,这对于新一代人工智能的模型来说,也应该是必备的技能,简而言之就是随机应变。比如要实现自动驾驶,汽车需要将模式识别和其它能力整合到一起,包括推理、规划和记忆。它需要识别模式,这样才能对障碍物和街道标志做出反应;它需要推理,这样才能理解交通规则和解决像避开障碍物等、任务;它需要规划以获得从当前位置到目标位置的路径,并同时考虑到交通状况等其它模式。它需要不断重复做这些事,同时不断更新它的解决方案。

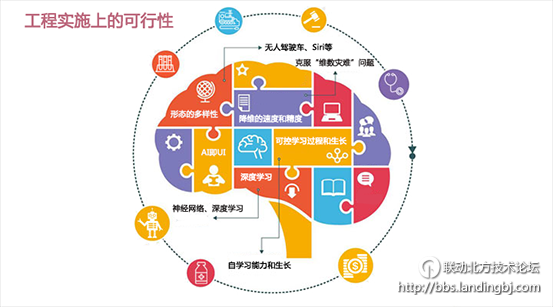

底线三:工程实施上可达(或者说,可行性)

【可控学习过程和生长】

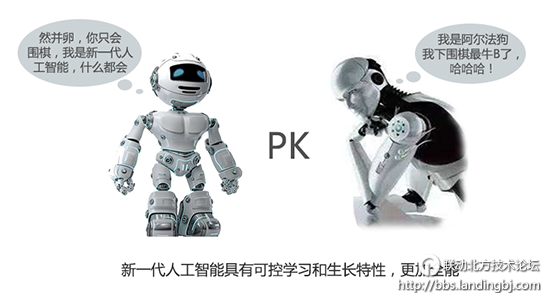

当前流行的做法,无论是走统计模型,还是走深度神经网络模型,都算是一种比较好的工程实现方法,可建模、可计算、可量化、也可达到特定目标,否则不会有那么广泛的参与;其实这也从一个侧面证明了,工程可行性对于科技的重要程度。但它们通常只能半学习某一种或者几种技能,比如阿尔法狗,他只是学习了如何下围棋,新一代的人工智能不应该只是这样子的,它应该是一个全能性的人才,会下围棋,会斗地主,会做饭等等,也就是说它需要能同时学习很多种技能。

所以对于模型而言,它应该具有可持续发展性,具有自学习和生长的能力,只要通过不断的可控的学习和生长,它就会越来越全能、越来越庞大、越来越健壮。所以说人工智能真正的其重心从“人工”转向“智能”,最核心的是自学习能力和生长,否则就只是验证知识的程序式实现而已。

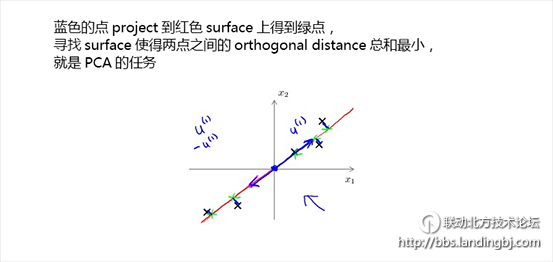

【降维的速度和精度】

人工智能各种模型都会面临一个普遍性的问题,就是维度一般较高,要控制好整体的收敛性和计算速度,就要对数据进行降维。因为高维度不仅会导致“维数灾”的问题,而且会使人们对数据集中所隐含的结构信息难以直观的理解和发现。所以当前人工智能计算力的角逐,很多都集中在降维领域,而这恰恰是各个公司的不传之秘,涉及到制高点的争夺。

不过通常来讲,降维一般都伴随着微小量处理,这里就有个粒度与精度的权衡;粒度不同,导致计算的精细度不同,导致摒弃的小量数不同;所以需要计算出一定误差范围内,需要的粒度指标,这也是里面的一个核心数学问题。

【形态的多样性】

从大众的角度看,所谓人工智能,就是要实现所有目前还无法不借助人类智慧才能实现的任务的集合。或许“人工智能”听起来总让人想起科幻小说或者科幻电影中的那些聪明的机器人,很有趣,但却缺乏真实感。可实际上机器人外形只不过是人工智能的容器之一,人工智能很早之前就以多种形态出现在生活之中。

结语:

如果说达尔文的进化论是人类关于自身起源的一次冲击,那么通用型人工智能的诞生便是对人类未来的另一次冲击。让我们扩大时间的尺度,想想十年前、百年前、千年前世界的样子,再看看我们现在的生活,不能说是天翻地覆,但显然得益于技术的发展,我们的生活有了更多的便捷;也不禁畅想未来,说不定下个奇点没有想象中的那么远,或许明年、或许明天。

该贴被联动北方管理员编辑于2017-3-2 16:21:28

该贴由system转至本版2017-3-29 12:42:21

技术讨论

技术讨论