昨天hadoop集群中一个数据节点到期,导致关机,续费开机后,hadoop进程正常开启,但今天早上看到MR运算结果为空,查看运算日志和zabbix监控获取如下报错日志和监控画面:

|

1 2 3

|

15/03/17 03:30:27 INFO hdfs.DFSClient: Exception in createBlockOutputStream 119.*.*.*:50010 java.io.IOException: Bad connect ack with firstBadLink as 119.*.*.*:50010 15/03/17 03:30:27 INFO hdfs.DFSClient: Abandoning block blk_2667475728482771870_391130 15/03/17 03:30:27 INFO hdfs.DFSClient: Excluding datanode 119.*.*.*:50010 |

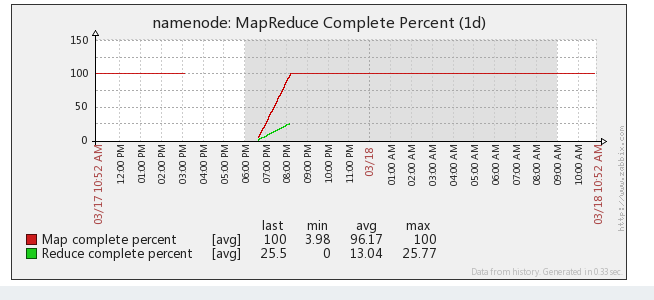

从监控画面可以看出,MR job从第一个开始就卡死了。然后,根据日志信息排查,最后确定主要是由于Hadoop集群内某些节点的防火墙没有关闭,导致无法访问集群内节点。关机重启后的datanode 119.*.*.* ,开机自动启动了iptables,关闭iptables后,再次运行MR,成功。

技术讨论

技术讨论